2026年3月4日

- 技術・研究開発

- Stories

- テクノロジー

- くらし

- ナノイー

Adobe Acrobat Readerの特定のバージョンに、一部のPDFが開けないバグが発生しております。PDFが開けない場合、お使いのAcrobat Readerを最新版へアップデートの上お試しください。

2020年10月15日

技術・研究開発 / プレスリリース

パナソニック株式会社(以下、パナソニック)と米国のStanford Vision & Learning Lab(SVL)は、世界最大規模*1の住空間向けAI開発用マルチモーダルデータセット*2「Home Action Genome」を構築し、研究者向けに公開しました。また、本データセットを用いた行動認識アルゴリズムの開発コンペティション「International Challenge on Compositional and Multimodal Perception(CAMP)」を行います。

「Home Action Genome」は、住宅内における人の日常行動を模したシーンを、カメラや熱センサなど数種類のセンサを用いて撮影・計測したデータセットです。データには、各シーンにおける人の行動内容を表すアノテーション*3が含まれています。

下記サイトよりご確認ください。

CAMPホームページ:https://camp-workshop.stanford.edu/

今まで公開されている住空間向けデータセットは、音声や映像のデータが主体で規模が小さいものが主流でした。今回、パナソニックのデータ計測技術とSVLのアノテーションノウハウを掛け合わせることで、世界最大規模の住空間向けマルチモーダルデータセットを実現しました。

AI研究者は、本データセットを機械学習の学習用データとして用いることができるとともに、住宅内の人をサポートするAI研究に活用することができます。

当社は、一人ひとりのくらしが日々良くなっていく「くらしアップデート」の実現に向けて、今後もデータセット公開を通した共創などにより、住宅分野向けAIの開発を加速してまいります。

70の行動カテゴリに対し、異なる場所および人物で取得した3500のシーンが含まれます。一つのシーンはおおよそ2~5分程度のシーケンスです。

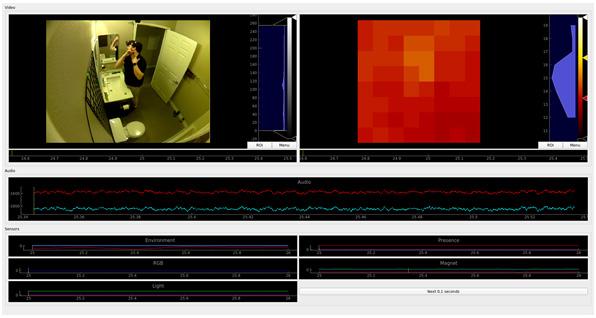

| データ種別 | 説明 |

|---|---|

| Video | カメラで取得した画像情報 |

| IR | 人や物体の熱を赤外線センサのグリッドで検知し,画像形式に整形した情報 |

| Audio | マイクで取得した音声情報 |

| RGB Light | 可視光の赤、緑、青の各スペクトルの光強度 |

| Light | 室内の明るさを表す情報 |

| Acceleration | ジャイロセンサ,加速度センサによる角加速度および加速度を表す情報 |

| Presence | 赤外線センサを用いた,人の在不在情報 |

| Magnet | 地磁気センサの情報 |

「髭を剃る」シーンで取得されたデータの一例

グラフは各センサで取得された情報を時系列に表したもの

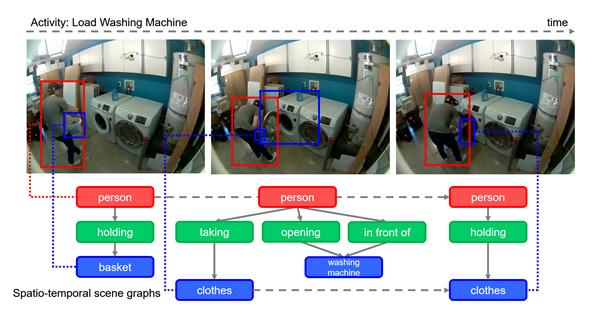

本マルチモーダルデータセットには下記の情報が付与されています。

※詳細情報は、CAMPホームページをご覧ください。

データセットに付与されたアノテーション情報の例

以上

記事の内容は発表時のものです。

商品の販売終了や、組織の変更などにより、最新の情報と異なる場合がありますので、ご了承ください。